NVIDIA Sana: Blitzschnelles Bildgenerierungsmodell für KI-Grafiken

Der Wettlauf um das beste Bildgenerierungsmodell geht weiter und wird immer intensiver. In diesem Jahr haben wir den Aufstieg von FLUX gesehen, der die vollständige Dominanz von Stable Diffusion XL in der Open-Source-Community ablöst, Ideogram und ReCraft, die Next-Gen-Modelle auf der Closed-Source-Seite eingeführt haben, die die Erwartungen übertreffen, und zahlreiche kleinere Projekte, die in verschiedenen Teilbereichen eigene Wege gehen.

NVIDIA Sana: Ein Regelbrecher

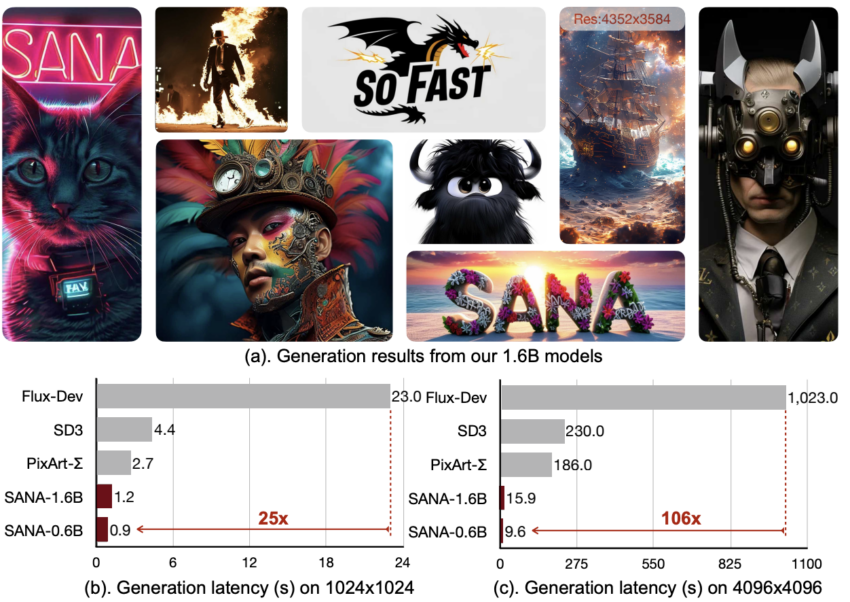

In diesem Artikel möchten wir Ihnen einen dieser Regelbrecher vorstellen, der unsere Aufmerksamkeit erregt hat: NVIDIA Sana. Dieses unglaublich schnelle Modell, obwohl erst kürzlich veröffentlicht, bietet eine Vielzahl wichtiger Eigenschaften, die unserer Meinung nach bei zukünftigen SOTA-Modellen zum Standard werden.

Was unterscheidet Sana von FLUX und Stable Diffusion?

Um zu beginnen, müssen wir erklären, wie sich Sana von seinen Vorgängern unterscheidet.

- Einzigartiges Autoencoder-Design mit tiefer Kompression und bis zu 32-facher Komprimierung.

- Lineares Aufmerksamkeitsmechanismus im Diffusion Transformer (DiT), Reduzierung der Komplexität von O(N²) auf O(N).

- Ersetzung des T5-Text-Encoders durch das kleinere, effizientere Gemma-Modell.

- Training mit dem Flow-DPM-Solver für weniger Sampling-Schritte, konkurrenzfähig mit FLUX bei 1/20 der Größe.

Sana Pipeline Übersicht

Die Sana Modellarchitektur: Autoencoder

Im Gegensatz zu früheren Designs verwendet der Autoencoder von Sana eine aggressive 32-fache Kompression. Dies reduziert die Anzahl der Token um das 4-fache und senkt die GPU-Speicherkosten.

Die Sana Modellarchitektur: Linear Diffusion Transformer

Sana verwendet einen linearen Aufmerksamkeitsmechanismus und das MIX-FFN mit einer 3×3-Tiefenkonvolution zur besseren Token-Informationsaggregation.

Die Sana Modellarchitektur: Ersetzung von T5

Sana integriert Googles Gemma-Encoder für eine bessere Verarbeitung menschlicher Eingaben mithilfe von Chain-of-Thought (CoT) und In-Context Learning (ICL).

Wie man Sana auf einer ccloud³ GPU ausführt

Conda installieren

Installieren Sie Miniconda, um die Sana-Umgebung zu verwalten:

cd ../home

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

bash Miniconda3-latest-Linux-x86_64.sh

Sana-Umgebung einrichten

Klonen Sie das Repository und richten Sie die Umgebung ein:

git clone https://github.com/NVlabs/Sana.git

cd Sana

./environment_setup.sh sana

conda activate sana

Sana in Jupyter Lab mit Python ausführen

Installiere Jupyter Lab

pip3 install jupyterlab

jupyter lab --allow-root

Sana Pipeline initialisieren

import torch

from app.sana_pipeline import SanaPipeline

from torchvision.utils import save_image

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

sana = SanaPipeline("configs/sana_config/1024ms/Sana_1600M_img1024.yaml")

sana.from_pretrained("hf://Efficient-Large-Model/Sana_1600M_1024px/checkpoints/Sana_1600M_1024px.pth")

Fazit von NVIDIA Sana

NVIDIA Sana ist ein spannendes Projekt, das die Grenzen der aktuellen Bildgenerierungsmodelle verschiebt. Seine beeindruckende Geschwindigkeit und Effizienz könnten es ermöglichen, mit etablierten Modellen zu konkurrieren. Ein großes Dankeschön an NVIDIA für die Open-Source-Bereitstellung dieser innovativen Technologie!