Die Schnittstelle zwischen Künstlicher Intelligenz und Neurowissenschaften

Die Kombination von Künstlicher Intelligenz (KI) und Neurowissenschaften ist nach wie vor ein spannendes Forschungsfeld. Das Studium der menschlichen Kognition überschneidet sich mit der Entwicklung intelligenter Maschinen und treibt Fortschritte in beiden Bereichen voran. Diese symbiotische Beziehung hat das Potenzial, unser Verständnis der Kognition zu revolutionieren und genauere Diagnosen sowie Behandlungen für neurologische Erkrankungen zu entwickeln.

Künstliche Intelligenz und ihre Rolle

Künstliche Intelligenz ist ein Bereich der Informatik, der sich mit der Entwicklung von Maschinen befasst, die menschliche Intelligenz nachahmen können. KI wird erfolgreich in verschiedenen Bereichen wie der medizinischen Diagnostik oder der Verarbeitung natürlicher Sprache eingesetzt.

Fortschritte in der Hardware haben technologische Veränderungen hin zur Entwicklung des maschinellen Lernens und tiefer Lernmethoden (Deep Learning) vorangetrieben. Nachhaltige neuromorphe Architekturen, die organische neuronale Strukturen nutzen, rücken die Entwicklung effizienter Rechensysteme in den Fokus und führen zu weiteren technologischen Durchbrüchen.

Neurowissenschaften: Das Gehirn verstehen

Neurowissenschaften sind ein Sammelbegriff für alle Aspekte der Erforschung des Gehirns und des Nervensystems. Dazu gehören Physiologie, Anatomie, Psychologie und sogar Informatik. Die Neurowissenschaften ermöglichen es uns, die Gehirnfunktion zu verstehen und so Erkenntnisse über deren Umsetzung in KI-Algorithmen zu gewinnen. Im Gegensatz dazu wird KI in der neurowissenschaftlichen Forschung genutzt, um große Mengen an Daten zur Gehirnfunktionalität und Pathologie zu analysieren.

Die Beziehung zwischen KI und Neurowissenschaften erforschen

Dieser Artikel befasst sich mit der wechselseitigen Beziehung zwischen Künstlicher Intelligenz (KI) und Neurowissenschaften.

Voraussetzungen

- Grundlegendes Verständnis von KI-Konzepten: Vertrautheit mit maschinellem Lernen, neuronalen Netzwerken und computergestütztem Modellieren.

- Interdisziplinärer Ansatz: Interesse an der Verbindung biologischer Prinzipien mit rechnergestützten Techniken.

- Analytische Fähigkeiten: Fähigkeit zur kritischen Analyse wissenschaftlicher Literatur und neuer Technologien.

Künstliche Neuronale Netzwerke

Künstliche neuronale Netzwerke (Artificial Neural Networks, ANNs) haben die KI nachhaltig verändert und Maschinen die Fähigkeit verliehen, Aufgaben auszuführen, die normalerweise menschliche Intelligenz erfordern. Sie ahmen die Architektur und Funktion neurobiologischer Netzwerke nach und reproduzieren grob die Art und Weise, wie Neuronen Informationen im Gehirn verarbeiten.

Obwohl ANNs in zahlreichen Anwendungen erfolgreich sind, kann die Beziehung zwischen ANN und Neurowissenschaften tiefere Einblicke in künstliche und biologische Intelligenz ermöglichen.

Die Grundlagen Künstlicher Neuronaler Netzwerke

Ein künstliches neuronales Netzwerk ist eine Sammlung miteinander verbundener künstlicher Knoten, die oft als Neuronen oder Einheiten bezeichnet werden. Diese verarbeiten eingehende Daten, indem sie verschiedene Schichten durchlaufen, in denen mathematische Operationen durchgeführt werden, um Erkenntnisse zu gewinnen und Vorhersagen zu treffen.

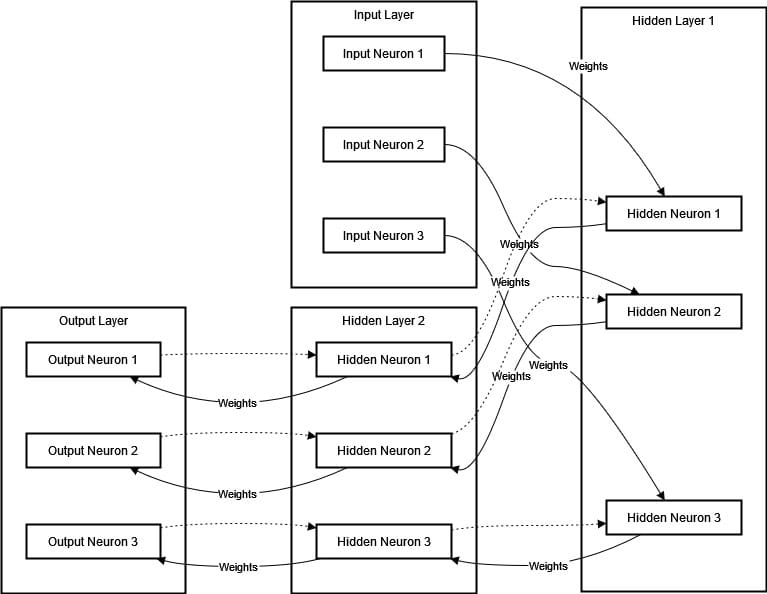

Ein ANN besteht aus mehreren Schichten, darunter eine Eingabeschicht, eine oder mehrere verborgene Schichten und eine Ausgabeschicht. Die Verbindungen zwischen den Neuronen werden als Gewichte bezeichnet. Diese Gewichte werden während des Trainings angepasst, um den Unterschied zwischen vorhergesagtem Ergebnis und tatsächlicher Ausgabe zu minimieren. Das Netzwerk lernt aus den Daten durch den sogenannten Backpropagation-Algorithmus, bei dem es sich wiederholt anpasst, indem es sich vor- und zurückbewegt. Das folgende Diagramm stellt ein künstliches neuronales Netzwerk (ANN) dar:

Das obige Diagramm zeigt ein künstliches neuronales Netzwerk (ANN) mit einer Eingabeschicht, zwei versteckten Schichten und einer Ausgabeschicht. Die Eingabedaten fließen durch die versteckten Schichten zur Ausgabeschicht. Jede Verbindung hat ein Gewicht, das in der Trainingsphase angepasst wird. Backpropagation wird durch gestrichelte Linien dargestellt und zeigt die Anpassung der Gewichte zur Minimierung von Fehlern.

Neuronale Netzwerke des Gehirns

Das menschliche Gehirn ist ein Netzwerk aus Milliarden von Neuronen, die das Nervensystem bilden. Neuronen kommunizieren über elektrische und chemische Signale, die oft in komplexen Netzwerken entstehen. Diese Netzwerke ermöglichen es dem Gehirn, Informationen zu kodieren, Entscheidungen zu treffen und Verhalten zu steuern.

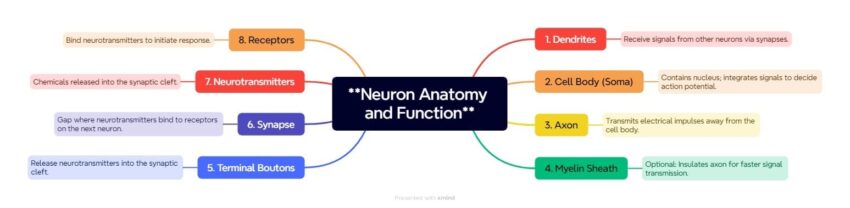

Die funktionelle Anatomie eines Neurons wird im obigen Diagramm dargestellt, um seine Komponenten und ihre Funktionen während der Signalübertragung zu veranschaulichen. Dendriten fungieren als Antennen für Neuronen und empfangen Signale von anderen Neuronen über synaptische Verbindungen. Der Zellkörper (Soma) verarbeitet diese Signale und entscheidet mit Hilfe seines Zellkerns, ob er ein Aktionspotenzial erzeugen soll.

Rekurrente Neuronale Netzwerke: Nachbildung des Gedächtnisses im Gehirn für sequenzielle Datenanalyse

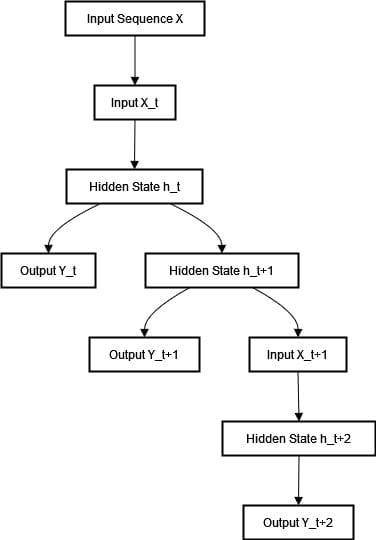

Rekurrente Neuronale Netzwerke (Recurrent Neural Networks, RNNs) speichern Informationen in ihren verborgenen Zuständen, um Muster in Datensequenzen zu erkennen. Im Gegensatz zu Feedforward-Netzwerken verarbeiten RNNs eine Eingabesequenz schrittweise.

Faltungsneuronale Netzwerke und das Gehirn: Ein Vergleich

Faltungsneuronale Netzwerke (Convolutional Neural Networks, CNNs) haben die Künstliche Intelligenz revolutioniert und sind von biologischen Prozessen inspiriert. Durch ihre mehrschichtige Analyse visueller Eingaben erkennen CNNs bedeutende Muster auf eine Weise, die dem hierarchischen Ansatz des menschlichen Gehirns ähnelt.

Ihre einzigartige Architektur ahmt nach, wie unser Gehirn abstrakte Repräsentationen der Welt extrahiert, indem es Filter- und Pooling-Operationen in der Sehrinde (visuellen Cortex) nutzt. So wie CNNs den Bereich der maschinellen Wahrnehmung verändert haben, kann ihr Vergleich mit dem Gehirn unser Verständnis von künstlicher und biologischer Sichtweise vertiefen.

Visuelles Verarbeitungssystem des Gehirns

Das menschliche Gehirn ist ein leistungsstarker Prozessor visueller Informationen. Der visuelle Kortex, der sich im Okzipitallappen am hinteren Teil des Gehirns befindet, ist besonders für die Verarbeitung visueller Informationen verantwortlich. Dabei nutzt er eine hierarchische Struktur von Neuronen. Diese Neuronen sind in Schichten organisiert, wobei jede Schicht verschiedene Aspekte der visuellen Szene verarbeitet – von einfachen Kanten und Texturen bis hin zu vollständigen Formen und Objekten. In den ersten Stufen reagieren Neuronen im visuellen Kortex auf einfache Reize wie Linien und Kanten. Während visuelle Informationen durch aufeinanderfolgende Schichten wandern, integrieren die Neuronen diese grundlegenden Merkmale zu komplexen Repräsentationen und führen letztendlich zur Objekterkennung.

Die Architektur von Faltungsneuronalen Netzwerken

CNNs versuchen, diesen Ansatz nachzubilden, und die resultierende Netzwerkarchitektur besteht aus mehreren Schichten. Faltungsschichten, Pooling-Schichten und vollständig verbundene Schichten sind verschiedene Arten von Schichten in einem CNN. Sie sind für die Erkennung spezifischer Merkmale im Eingangsbild verantwortlich, wobei jede Schicht ihre Ausgaben an die folgenden Schichten weiterleitet. Sehen wir uns jede dieser Schichten genauer an:

- Faltungsschichten: Diese Schichten verwenden Filter, um das Eingangsbild zu analysieren und lokale Merkmale wie Kanten oder Texturen zu erkennen. Jeder Filter verhält sich wie ein rezeptives Feld und erfasst lokale Bereiche in den Eingangsdaten, ähnlich wie die rezeptiven Felder von Neuronen im visuellen Kortex.

- Pooling-Schichten: Diese Schichten reduzieren die räumlichen Dimensionen der Daten, während sie dennoch wichtige Merkmale bewahren. Dies entspricht der Art und Weise, wie das menschliche Gehirn visuelle Informationen verdichtet und priorisiert.

- Vollständig verbundene Schichten: In den letzten Phasen integrieren die letzten Schichten alle erkannten Merkmale. Dies ähnelt dem Prozess im Gehirn, bei dem komplexe Merkmale integriert werden, um ein Objekt zu erkennen und eine endgültige Klassifikation oder Entscheidung zu treffen.

Ähnlichkeiten und Unterschiede

Die Ähnlichkeit zwischen künstlichen neuronalen Netzwerken für computerbasierte Sehverarbeitung und dem komplexen visuellen System biologischer Organismen liegt in ihrer hierarchischen Architektur. In CNNs ergibt sich diese Hierarchie durch simulierte Neuronen, die mathematische Operationen durchführen. In lebenden Organismen basiert sie auf tatsächlichen Neuronen, die elektrochemische Signale austauschen.

Allerdings gibt es erhebliche Unterschiede. Die Fähigkeit des Gehirns zur Verarbeitung visueller Informationen übertrifft aktuelle Algorithmen in Bezug auf Komplexität und Dynamik erheblich. Biologische Neuronen besitzen interaktive, erfahrungsgetriebene Plastizität, die in künstlichen Netzwerken bislang nicht vollständig nachgebildet werden kann. Darüber hinaus verarbeitet das Gehirn nicht nur visuelle Informationen isoliert, sondern kombiniert diese mit anderen Sinneseindrücken und Kontextinformationen, um ein umfassenderes Verständnis der Umgebung zu entwickeln.

Verstärkendes Lernen und das Gehirn: Eine Untersuchung der Verbindungen

Eine Parallele zwischen Verstärkendem Lernen (Reinforcement Learning, RL) und dem menschlichen Gehirn besteht darin, dass beide Systeme durch Interaktion mit ihrer Umgebung lernen. Das Forschungsfeld der Künstlichen Intelligenz wird zunehmend durch RL-Algorithmen geprägt. Dies ermöglicht ein besseres Verständnis der Lernstrategien des Gehirns und ihrer Beziehung zu künstlichen Systemen.

Verstärkendes Lernen

Verstärkendes Lernen (Reinforcement Learning, RL) ist eine Art des maschinellen Lernens, bei der ein Agent durch Interaktion mit seiner Umgebung lernt, Entscheidungen zu treffen. Er erhält Belohnungen oder Bestrafungen für seine Handlungen. Nach ausreichend vielen Durchläufen erkennt der Lernalgorithmus, welche Aktionen zur Maximierung der kumulierten Belohnung führen, und entwickelt eine optimierte Strategie zur Entscheidungsfindung.

RL umfasst zentrale Komponenten:

- Agent: Er trifft Entscheidungen, um ein Ziel zu erreichen.

- Umgebung: Alles außerhalb des Agenten, mit dem er interagieren kann und von dem er Feedback erhält.

- Aktionen: Die verschiedenen Handlungen, die der Agent ausführen kann.

- Belohnungen: Die Umgebung vergibt positive oder negative Punkte nach jeder Entscheidung, um dem Agenten seine Leistung zu signalisieren.

- Politik: Die Strategie, die der Agent zur Bestimmung seiner Handlungen verfolgt.

Das Lernsystem des Gehirns

Ähnlich wie RL-Algorithmen operiert das menschliche Gehirn in einer Umgebung, die Verstärkungssignale während des Lernens bereitstellt. Besonders im Zusammenhang mit verstärkendem Lernen spielen einige Mechanismen eine entscheidende Rolle:

- Neuronale Schaltkreise: Netzwerke von Neuronen, die Informationen aufnehmen und Entscheidungsfindungen beeinflussen.

- Dopaminsystem: Ein Neurotransmittersystem, das an der Belohnungsverarbeitung und am verstärkenden Lernen beteiligt ist. Dopaminsignale fungieren als Belohnungsfeedback, das zukünftiges Verhalten anpasst.

- Präfrontaler Kortex: Eine Gehirnregion, die an der Planung, Entscheidungsfindung und Bewertung möglicher Belohnungen oder Bestrafungen beteiligt ist.

Ähnlichkeiten zwischen Verstärkendem Lernen und Gehirnlernen

- Versuch und Irrtum: RL-Algorithmen und das Gehirn lernen durch Versuch und Irrtum. RL-Agenten testen verschiedene Aktionen, um herauszufinden, welche die besten Belohnungen liefern. Ebenso probiert das Gehirn verschiedene Verhaltensweisen aus, um herauszufinden, welche am effektivsten sind.

- Belohnungsbasiertes Lernen: In RL lernen Agenten aus ihren Belohnungen. Dopaminsignale motivieren das Gehirn, Verhaltensweisen zu verstärken, die zu positiven Ergebnissen führen, und solche zu reduzieren, die negative Ergebnisse verursachen.

- Wertfunktion: Mithilfe von Wertfunktionen kann ein RL-Algorithmus erwartete Belohnungen für verschiedene Aktionen abschätzen. Ähnliche Mechanismen nutzt das Gehirn zur Bewertung potenzieller Belohnungen und zur Entscheidungsfindung.

- Erkundung vs. Ausnutzung: RL-Agenten balancieren zwischen Erkunden (Ausprobieren neuer Aktionen) und Ausnutzen (Verwenden bekannter, erfolgreicher Aktionen). Das Gehirn verfolgt ebenfalls eine Balance zwischen neuen Verhaltensweisen und bewährten Strategien.

Unterschiede und Fortschritte

Obwohl RL-Algorithmen von Gehirnfunktionen inspiriert sind, gibt es große Unterschiede. Werfen wir einen Blick auf einige davon:

Komplexität

Das Lernsystem des Gehirns ist weitaus komplexer und dynamischer als selbst die fortschrittlichsten aktuellen RL-Algorithmen. Das Gehirn kann sensorische Informationen aus verschiedenen Quellen gleichzeitig verarbeiten, sich in Echtzeit anpassen und mit hoher Flexibilität agieren.

Transferlernen

Menschen können gelerntes Wissen auf neue Situationen übertragen – eine Fähigkeit, die für viele RL-Systeme nach wie vor eine Herausforderung darstellt. In neuen Umgebungen oder Aufgaben erfordern die meisten RL-Algorithmen umfangreiches Neutrainieren.

Multimodales Lernen

Das Gehirn ist ein multimodaler Lernmechanismus, der verschiedene sensorische Eingaben kombiniert, um effizienter zu lernen. Die meisten fortgeschrittenen RL-Systeme hingegen fokussieren sich nur auf eine Art der Interaktion oder Umgebung.

Die Symbiose zwischen RL und Neurowissenschaften

Die Verbindung zwischen RL und dem Gehirn ist bidirektional. Erkenntnisse aus den Neurowissenschaften fließen in das Design von RL-Algorithmen ein. Dies führt zu ausgefeilteren Modellen, die gehirninspirierte Lernprozesse nachbilden. Gleichzeitig kann die Weiterentwicklung von RL helfen, ein Erklärungsmodell für die Gehirnfunktion zu entwickeln und die computergestützte Neurowissenschaft zu unterstützen.

Use Case: Verbesserung autonomer Fahrsysteme durch Verstärkendes Lernen

Fortgeschrittene Algorithmen ermöglichen es autonomen Fahrzeugen, komplexe Umgebungen zu navigieren, sofortige Entscheidungen zu treffen und die Sicherheit der Passagiere zu gewährleisten. Dennoch schneiden viele der aktuellen Algorithmen in unvorhersehbaren Szenarien schlecht ab.

Dazu gehören unerwartete Verkehrsströme, Wetterbedingungen und unregelmäßiges Fahrverhalten anderer Verkehrsteilnehmer. Solche Anforderungen erfordern zunehmend eine Reaktion, die dem menschlichen Gehirn ähnelt – ein adaptives und dynamisches Entscheidungsfindungssystem.

Lösung

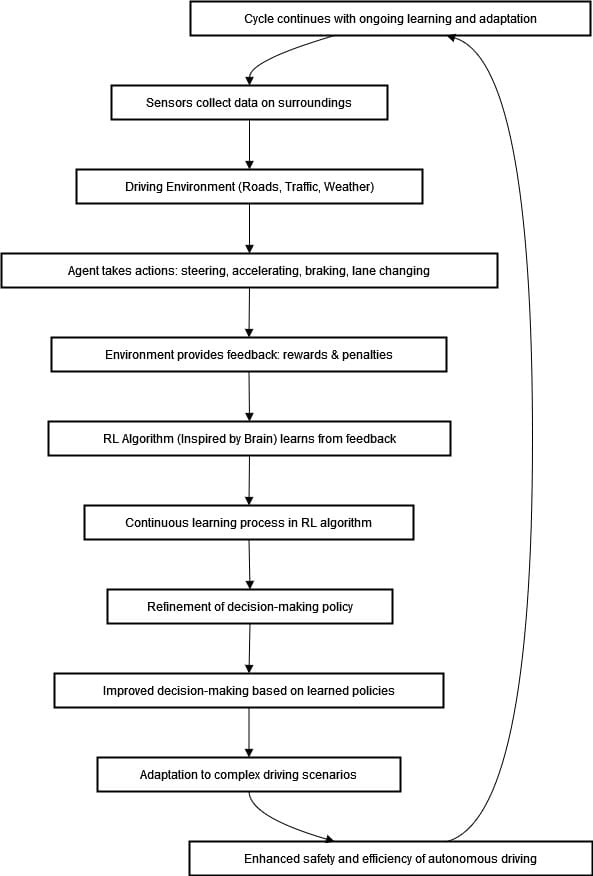

Durch den Einsatz von Verstärkendem Lernen (RL) können autonome Fahrsysteme menschliches Lernen nachahmen und ihre Entscheidungsfindung verbessern. RL ermöglicht es dem System, aus Belohnungen zu lernen und sich an neue Szenarien anzupassen. Dadurch kann die Leistung dieser Systeme unter realen Fahrbedingungen verbessert werden.

Das autonome Fahrzeug (Agent) interagiert mit seiner Umgebung, erhält Feedback durch Sensoren und passt sein Verhalten mithilfe von RL-Algorithmen an. Durch kontinuierliches Lernen und die Verfeinerung seiner Strategie verbessert das System seine Entscheidungsfindung fortlaufend und unterstützt komplexe Szenarien, die die Fahrsicherheit und Effizienz weiter steigern.

Tiefes Verstärkendes Lernen

Tiefes Verstärkendes Lernen (Deep Reinforcement Learning, DRL) ist eine leistungsstarke Gruppe von Algorithmen, die einem Agenten beibringt, sich in einer Umgebung durch Deep-Learning- und Verstärkungslern-Prinzipien zu verhalten. Diese Methode ermöglicht es Maschinen, durch Versuch und Irrtum zu lernen – ähnlich wie Menschen oder andere Lebewesen.

Die zugrunde liegenden Prinzipien von DRL weisen Parallelen zu den Lernprozessen des Gehirns auf. Dadurch kann es wertvolle Einblicke in künstliche und biologische Intelligenz liefern.

Parallelen zwischen DRL und dem Gehirn

- Hierarchisches Lernen: Das Gehirn und tiefes Verstärkendes Lernen nutzen mehrstufige Abstraktionen. Das Gehirn verarbeitet sensorische Informationen schrittweise, wobei jede Stufe immer komplexere Merkmale extrahiert. Ähnlich erlernen tiefe neuronale Netze in DRL grundlegende Strukturen (in frühen Schichten) und komplexe Muster (in tieferen Schichten).

- Kreditzuweisung: Eine Herausforderung sowohl im DRL als auch im Gehirn besteht darin, zu bestimmen, welche Handlungen für Belohnungen verantwortlich sind. Die Verstärkungslern-Schaltkreise des Gehirns, insbesondere im präfrontalen Kortex und den Basalganglien, helfen bei der Zuschreibung von Belohnungen. DRL nutzt hierfür Techniken wie Backpropagation durch die Zeit und Temporal-Difference-Lernen.

- Generalisierung und Transferlernen: Das Gehirn ist hervorragend darin, Wissen von einer Aufgabe auf eine andere zu übertragen. Zum Beispiel erleichtert das Lernen, Fahrrad zu fahren, das Erlernen des Motorradfahrens. DRL beginnt, ähnliche Fortschritte zu erzielen, indem Agenten Wissen über verschiedene Aufgaben oder Umgebungen hinweg transferieren. Dies bleibt jedoch ein aktives Forschungsfeld.

Fortschritte und Herausforderungen

DRL hat sich weit entwickelt, ist aber immer noch weit davon entfernt, gehirnähnliches Lernen in all seinen Feinheiten zu erfassen. Verbesserungen könnten in Bereichen wie der nahtlosen Integration multimodaler Informationen (Sehen, Hören, Tasten), der Robustheit gegenüber verrauschten oder unvollständigen Daten sowie der Effizienz beim Lernen aus begrenzten Erfahrungen erfolgen. In der DRL-Forschung nimmt die Neurowissenschaft bereits eine zentrale Rolle ein. Neue Ansätze werden untersucht, darunter Neuromodulation (die nachahmt, wie Neurotransmitter das Lernen im Gehirn steuern) sowie speichererweiterte Netzwerke, die einige einzigartige Eigenschaften des menschlichen Gedächtnisses imitieren.

Spiking Neuronale Netzwerke

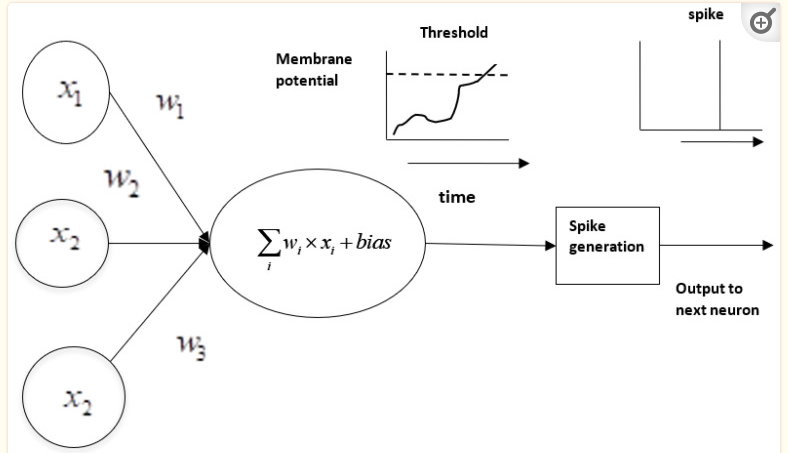

Spiking Neuronale Netzwerke (Spiking Neural Networks, SNNs) sind eine Art neuronales Modell, das die Dynamik biologischer Neuronen berücksichtigt. Anstatt kontinuierliche Werte für Neuronenaktivierungen zu verwenden, setzen SNNs auf diskrete Impulse oder Spikes. Diese Spikes entstehen, sobald das Membranpotenzial eines Neurons eine bestimmte Schwelle überschreitet, wie im folgenden Bild dargestellt. Diese Spikes basieren auf den Aktionspotenzialen biologischer Neuronen.

Wichtige Merkmale von Spiking Neuronalen Netzwerken

- Temporale Dynamik: SNNs modellieren die zeitliche Abfolge von Spikes und ermöglichen es, zeitliche Muster und Dynamiken zu erfassen, die entscheidend für das Verständnis der Gehirnfunktion sind.

- Ereignisbasierte Verarbeitung: Neuronen in SNNs werden nur aktiviert, wenn ein Spike auftritt. Diese ereignisgesteuerte Natur macht sie effizienter und näher an der Informationsverarbeitung biologischer Gehirne.

- Synaptische Plastizität: SNNs können verschiedene Formen der synaptischen Plastizität modellieren, darunter Spike-Timing-abhängige Plastizität (STDP), ein Mechanismus, der die Stärke von Verbindungen basierend auf der zeitlichen Abfolge von Spikes anpasst.

Verbindung zur Neurowissenschaft

Spiking Neuronale Netzwerke (SNNs) sollen das Verhalten biologischer Neuronen besser nachbilden als traditionelle neuronale Netzwerke. Sie dienen als Modell für neuronale Aktivitäten und deren elektrische Reaktionen beim Empfang und der Übertragung von Spikes unter zeitdynamischen Bedingungen.

Sie bieten Forschern Einblicke in die Kodierung und Verarbeitung von Informationen in biologischen Neuronen. Dies kann helfen zu verstehen, wie sensorische Informationen kodiert werden und welche Rolle sie bei Lern- und Gedächtnisprozessen spielen.

SNNs sind ein zentraler Bestandteil des neuromorphen Computings, das darauf abzielt, Hardware zu entwickeln, die die Effizienz und Leistungsfähigkeit des menschlichen Gehirns nachahmt. Dies ermöglicht energieeffizientere und vielseitigere Computersysteme.

Anwendungen von Spiking Neuronalen Netzwerken

- SNNs können Muster in Datenströmen wie visuellen oder auditiven Eingaben erkennen.

- Sie sind darauf ausgelegt, zeitliche Muster oder Echtzeit-Datenströme zu verarbeiten und zu erkennen.

- Sie werden für die sensorische Verarbeitung und motorische Steuerung in der Robotik eingesetzt.

- Sie sind ereignisgesteuert und daher ideal für Echtzeit-Entscheidungen, insbesondere in dynamischen Umgebungen.

- SNNs können auch in Gehirn-Maschine-Schnittstellen (Brain-Machine Interfaces, BMIs) verwendet werden, um neuronale Signale zur Steuerung externer Geräte zu interpretieren.

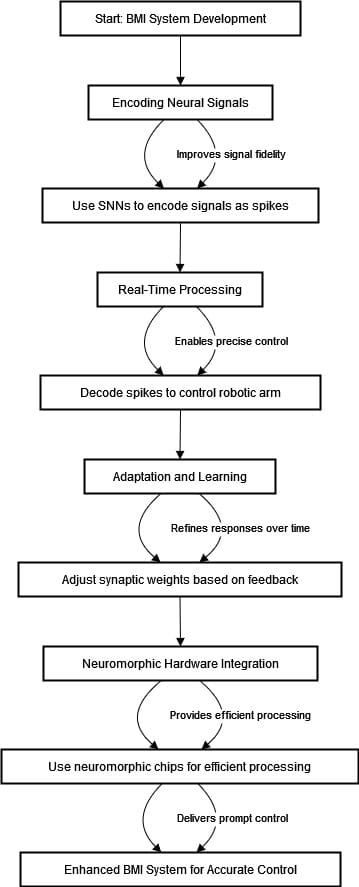

Use Case: Verbesserung von Gehirn-Maschine-Schnittstellen mit Spiking Neuronalen Netzwerken (SNNs)

Gehirn-Maschine-Schnittstellen (BMIs) sind Systeme, die neuronale Signale erkennen und in Befehle umwandeln, die von einem externen Gerät verarbeitet werden können. Sie haben großes Potenzial in der Forschung, unter anderem zur Unterstützung von Menschen mit neurologischen Erkrankungen, zur Verbesserung kognitiver Funktionen und zur Entwicklung hochmoderner Prothesen.

Spiking Neuronale Netzwerke (SNNs) bieten eine Alternative zu bestehenden Ansätzen, die sich für ideale BMIs als weniger effizient erwiesen haben. Sie sind von den neuronalen Mechanismen des Gehirns inspiriert. Unser Ziel ist es, die Genauigkeit und Reaktionsfähigkeit eines BMI zur Steuerung eines Roboterarms allein durch Gedanken zu verbessern.

Lösung

Das obige Diagramm zeigt ein Flussdiagramm für die Entwicklung eines durch Spiking Neuronale Netzwerke (SNNs) verbesserten Gehirn-Maschine-Schnittstellensystems (BMI). Die erste Phase umfasst die Kodierung neuronaler Signale mit SNNs, die kontinuierliche Gehirnsignale in diskrete Spikes umwandeln. Diese Kodierung verbessert die Signalqualität und ermöglicht eine bessere Annäherung an reale Gehirnaktivitäten.

Die folgenden Phasen umfassen die Echtzeitverarbeitung, in der die zeitliche Abfolge und Reihenfolge dieser Spikes dekodiert wird. Dies ermöglicht eine präzise Steuerung des Roboterarms, die durch neuronale Absichten gesteuert wird.

Nach der Echtzeitverarbeitung kann sich das System anpassen und lernen. SNNs passen synaptische Gewichte basierend auf den Bewegungen des Roboterarms an und optimieren so die Reaktionen des Netzwerks durch einen Lernprozess. Die letzte Phase konzentriert sich auf die Integration neuromorpher Hardware, die eine gehirnähnliche Verarbeitung von Spikes ermöglicht. Solche Hardware verbessert die Energieeffizienz und die Echtzeitverarbeitung.

Das Ergebnis ist ein optimiertes BMI-System, das den Roboterarm schnell und präzise steuern kann. Schließlich stellt dies eine fortschrittliche Methode zur Entwicklung von BMIs dar, die die biologische Realität von SNNs nutzt, um besser geeignete und anpassungsfähige Algorithmen zu schaffen.

Fazit

Künstliche Intelligenz (KI) und Neurowissenschaften sind ein vielversprechendes Forschungsfeld, das beide Bereiche kombiniert. KI bezieht sich auf die Simulation menschlicher Intelligenz in Maschinen, die für Aufgaben wie medizinische Diagnosen und die Verarbeitung natürlicher Sprache entwickelt wurden. Fortschritte in der Hardware haben den Übergang vom maschinellen Lernen zum tiefen Lernen ermöglicht, wobei neuroinspirierte Architekturen organische neuronale Strukturen für effizientere Berechnungen nutzen.

Künstliche neuronale Netzwerke (ANNs) sind künstliche Versionen biologischer Netzwerke mit beeindruckenden KI-Funktionalitäten. RNNs und CNNs sind von Prozessen im Gehirn inspiriert, um Muster in sequenziellen Daten und visuellen Informationen zu erkennen.

Verstärkendes Lernen (RL) ahmt nach, wie das Gehirn durch Versuch und Irrtum lernt, mit Auswirkungen auf autonomes Fahren und andere Bereiche. Tiefes Verstärkendes Lernen (DRL) erforscht weiter die Lernprozesse der KI. Spiking Neuronale Netzwerke (SNNs) modellieren das Verhalten biologischer Neuronen noch genauer.