Adversariale Angriffe im maschinellen Lernen

Im Bereich des maschinellen Lernens und der künstlichen Intelligenz haben adversariale Angriffe viel Aufmerksamkeit von Forschern erhalten. Diese Angriffe verändern die Eingaben, um das Modell in die Irre zu führen und falsche Vorhersagen zu erzwingen. Unter diesen ist die Fast Gradient Sign Method (FGSM) besonders erwähnenswert, da sie sowohl effektiv als auch einfach ist.

Bedeutung von FGSM

Die Bedeutung von FGSM liegt in der Fähigkeit, die Anfälligkeit moderner Modelle für geringfügige Variationen in den Eingabedaten offenzulegen. Diese Störungen, die von menschlichen Beobachtern oft nicht wahrgenommen werden, führen zu Fehlern in der Vorhersagegenauigkeit. Das Verständnis und die Minimierung dieser Schwachstellen sind entscheidend für den Aufbau fehlertoleranter maschineller Lernsysteme, die in praktischen Anwendungen wie autonomem Fahren, Gesundheitsversorgung und Sicherheitsmanagement zuverlässig eingesetzt werden.

Dieser aufschlussreiche Artikel gibt einen tiefen Einblick in die Bedeutung von FGSM und erläutert seine mathematischen Grundlagen mit Klarheit und Präzision. Es werden Demonstrationen anhand einer anschaulichen Fallstudie bereitgestellt.

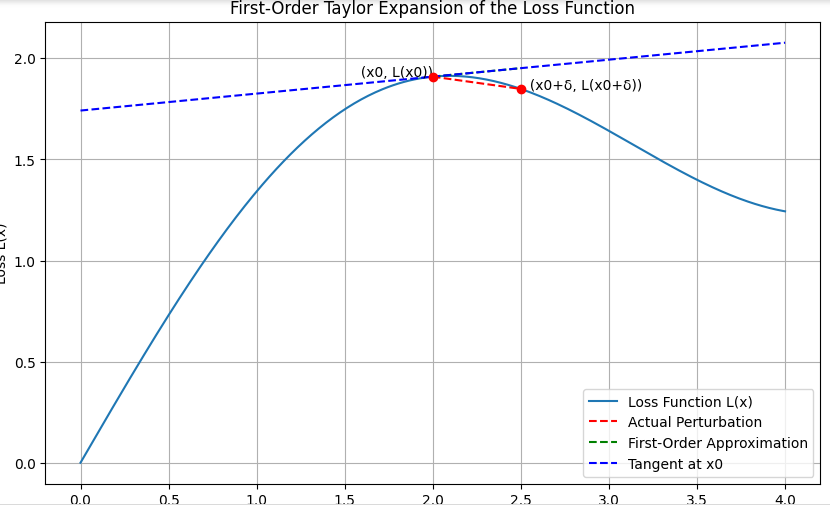

Erstordnungs-Taylor-Entwicklung bei adversarialen Angriffen

Die Nutzung der Erstordnungs-Taylor-Entwicklung zur Näherung der Verlustfunktion ist eine bedeutende Methode, um zu verstehen, wie kleine Änderungen an der Eingabe den Verlust in maschinellen Lernmodellen beeinflussen können. Dieser Ansatz ist besonders nützlich bei adversarialen Angriffen und beinhaltet die Berechnung einer Näherung von L(x+δ) unter Verwendung seines Gradienten mit einer Taylor-Entwicklung um x:

L(x+δ) ≈ L(x) + ∇L(x) ⋅ δ

L(x) bezeichnet den Verlust bei der ursprünglichen Eingabe x, während ∇L(x) den Gradienten der Verlustfunktion an dieser Stelle darstellt. Die Variable δ beschreibt eine kleine Störung von x. ∇L(x) gibt sowohl die Richtung als auch die Geschwindigkeit des steilsten Anstiegs der Verlustfunktion an. Wenn sich x in Richtung ∇L(x) verändert, lässt sich vorhersagen, wie sich die Verlustfunktion verändert.

Adversariale Angriffe setzen die Taylor-Entwicklung ein, um Störungen δ zu bestimmen, die den Verlust L(x+δ) maximieren. Dazu wählen sie δ proportional zum Vorzeichen von ∇L(x):

δ = ϵ ⋅ sign(∇L(x))

wobei ϵ eine kleine Skalierungsgröße ist, die die Größe der Störung kontrolliert.

Zur Veranschaulichung zeichnen wir ein Diagramm, das die Erstordnungs-Taylor-Entwicklung der Verlustfunktion darstellt. Dieses umfasst die Verlustkurve, den ursprünglichen Punkt, den Gradientenvektor, den gestörten Punkt und die Erstordnungs-Näherung.

Erstordnungs-Taylor-Entwicklung der Verlustfunktion

Das generierte Diagramm veranschaulicht die wichtigsten Konzepte der Erstordnungs-Taylor-Entwicklung der Verlustfunktion. Hier sind die zentralen Erkenntnisse:

- Verlustkurve (L(x)): Eine glatte Kurve, die die Verlustfunktion über verschiedene Eingaben hinweg darstellt.

- Ursprünglicher Punkt (x0, L(x0)): Der Punkt auf der Verlustkurve, der dem Wert der Eingabe x0 entspricht.

- Gradientenvektor (∇L(x0)): Dieser stellt die Steigung der Tangente am Punkt L(x0) dar.

- Gestörter Punkt (x0 + δ, L(x0 + δ)): Der neue Punkt nach Hinzufügen einer kleinen Störung δ zur Eingabe x0.

- Erstordnungs-Näherung (L(x0) + ∇L(x0) ⋅ δ): Die lineare Näherung der Verlustfunktion um x0.

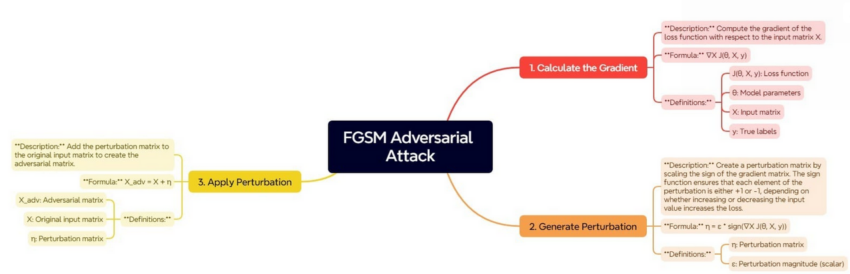

FGSM-Adversarial-Angriffsprozess

Forscher zeigen, wie der Gradient der Verlustfunktion die Veränderung des Verlusts durch kleine Störungen in der Eingabe approximieren kann. Dieses Verständnis spielt eine entscheidende Rolle bei der Generierung adversarieller Beispiele im Kontext adversarieller Angriffe.

Die Fast Gradient Sign Method (FGSM) nutzt die Gradienten der Verlustfunktion in Bezug auf die Eingabedaten, um die Richtung zu bestimmen, in die sich die Eingabe verändern muss, um den Modellfehler zu erhöhen. Die Schritte von FGSM können im folgenden Bild dargestellt werden:

FGSM-Adversarial-Angriffsprozess

Dieser Prozess beginnt mit der Bestimmung des Gradienten der Verlustfunktion in Bezug auf die Eingabedaten. Der Gradient zeigt, wie sich die Verlustfunktion verändert, wenn die Eingabedaten leicht modifiziert werden. Wer diese Beziehung versteht, kann die Richtung bestimmen, in die kleine Verschiebungen der Eingaben den Verlust erhöhen.

Nach der Berechnung des Gradienten folgt als nächster Schritt die Erzeugung der Störung. Dazu wird das Vorzeichen des Gradienten skaliert. Die Vorzeichenfunktion stellt sicher, dass jede Komponente der Störungsmatrix entweder +1 oder -1 ist. Dies zeigt an, ob der Verlust am empfindlichsten auf eine Erhöhung oder Verringerung des entsprechenden Eingabewerts reagiert.

Der Skalierungsfaktor stellt sicher, dass diese Störungen klein genug sind, um nicht erkennbar zu sein, aber groß genug, um das Modell zu täuschen.

Der letzte Schritt besteht darin, das adversariale Beispiel zu generieren, indem diese Störung auf die ursprüngliche Eingabe angewendet wird. Durch das Hinzufügen der Störungsmatrix zur ursprünglichen Eingabematrix erhalten wir eine Eingabe, die der Originaldaten sehr ähnlich sieht, aber darauf ausgelegt ist, das Modell zu falschen Vorhersagen zu verleiten.

Nutzung und Bedeutung von FGSM im maschinellen Lernen

- Testen der Modellrobustheit: FGSM wird verwendet, um die Widerstandsfähigkeit eines maschinellen Lernmodells gegen adversariale Angriffe zu bewerten.

- Verbesserung der Modellsicherheit: Robuste Modelle sind entscheidend für sicherheitskritische Anwendungen wie autonomes Fahren, Gesundheitswesen und Finanzwesen.

- Adversariales Training: Es unterstützt das adversariale Training, indem es das Modell potenziellen Angriffen aussetzt und so seine Robustheit verbessert.

- Verständnis des Modellverhaltens: FGSM hilft dabei, das Verhalten des Modells unter Eingabestörungen zu verstehen.

- Benchmarking adversarieller Abwehrtechniken: Es wird verwendet, um Abwehrtechniken gegen adversariale Angriffe zu vergleichen.

- Bildungszwecke: FGSM dient als grundlegende Einführung in adversariale Angriffe und Abwehrmaßnahmen im maschinellen Lernen.

Praktische Umsetzung

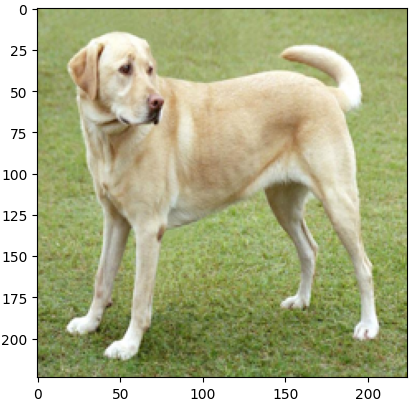

Um den Fast Gradient Sign Method (FGSM)-Angriff praktisch zu demonstrieren, verwenden wir TensorFlow zur Generierung adversarieller Beispiele. Wir nutzen Gradio als interaktives Anzeigetool, um die Ergebnisse darzustellen. Wir verwenden ein Bild eines gelben Labrador Retrievers, das hier zu finden ist.

Zunächst laden wir die notwendigen Bibliotheken und das Bild:

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

import gradio as gr

import requests

from PIL import Image

from io import BytesIO

# Bild laden

image_url = "https://storage.googleapis.com/download.tensorflow.org/example_images/YellowLabradorLooking_new.jpg"

response = requests.get(image_url)

img = Image.open(BytesIO(response.content))

img = img.resize((224, 224))

img = np.array(img) / 255.0

# Bild anzeigen

plt.imshow(img)

plt.show()

Ausgabe:

FGSM-Angriffs-Funktion

Der obige Python-Code lädt ein Bild aus einer bestimmten URL und zeigt es an. Dabei kommen Bibliotheken wie TensorFlow, NumPy, Matplotlib und PIL zum Einsatz. Die requests-Bibliothek ruft das Bild ab. Anschließend skaliert das Programm das Bild auf eine Größe von 224×224 Pixel und normalisiert die Pixelwerte auf einen Bereich zwischen 0 und 1, bevor es das Bild in ein NumPy-Array umwandelt.

Zum Abschluss zeigt das Programm das Bild an, sodass Nutzer überprüfen können, ob es korrekt geladen und verarbeitet wurde.

Als Nächstes laden wir ein vortrainiertes Modell und definieren die FGSM-Angriffs-Funktion:

# Ein vortrainiertes Modell laden

model = tf.keras.applications.MobileNetV2(weights='imagenet')

# FGSM-Angriffs-Funktion definieren

def fgsm_attack(image, epsilon):

image = tf.convert_to_tensor(image, dtype=tf.float32)

image = tf.expand_dims(image, axis=0)

with tf.GradientTape() as tape:

tape.watch(image)

prediction = model(image)

loss = tf.keras.losses.categorical_crossentropy(tf.keras.utils.to_categorical([208], 1000), prediction)

gradient = tape.gradient(loss, image)

signed_grad = tf.sign(gradient)

adversarial_image = image + epsilon * signed_grad

adversarial_image = tf.clip_by_value(adversarial_image, 0, 1)

return adversarial_image.numpy().squeeze()

# Adversariales Bild anzeigen

adversarial_img = fgsm_attack(img, epsilon=0.08)

plt.imshow(adversarial_img)

plt.show()

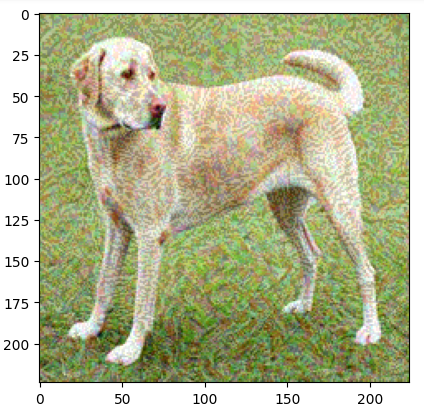

Ausgabe:

Der obige Code demonstriert die Durchführung eines FGSM-Angriffs auf ein Bild. Zunächst lädt das Programm ein vortrainiertes MobileNetV2-Modell mit Imagenet-Gewichten.

Die Funktion fgsm_attack führt den adversarialen Angriff aus. Sie transformiert das Eingabebild in einen Tensor, berechnet die Modellvorhersage und bestimmt den Verlust in Bezug auf das Ziel-Label. TensorFlows Gradient Tape berechnet den Verlust in Bezug auf die Eingabe, während das Vorzeichen des Gradienten zur Erzeugung der Störung dient. Diese wird dann mit einem Faktor epsilon multipliziert, um ein adversariales Bild zu erzeugen. Schließlich wird das Bild so beschnitten, dass es innerhalb des gültigen Pixelbereichs bleibt.

Integration von FGSM mit Gradio für interaktive Exploration

Abschließend integrieren wir FGSM mit Gradio, um eine interaktive Erkundung des adversarialen Angriffs zu ermöglichen:

# Gradio-Interface definieren

def generate_adversarial_image(epsilon):

adversarial_img = fgsm_attack(img, epsilon)

return adversarial_img

interface = gr.Interface(

fn=generate_adversarial_image,

inputs=gr.Slider(minimum=0.0, maximum=0.1, value=0.01, label="Epsilon"),

outputs=gr.Image(type="numpy", label="Adversariales Bild"),

live=True

)

# Gradio-Interface starten

interface.launch()

Ausgabe:

Der obige Code definiert die Funktion generate_adversarial_image. Sie akzeptiert den Epsilon-Wert als Parameter, führt den FGSM-Angriff auf das Bild aus und gibt das adversariale Bild aus.

Das Gradio-Interface enthält einen Schieberegler, mit dem der Epsilon-Wert angepasst werden kann, während die Aktualisierungen in Echtzeit über den Parameter live=True angezeigt werden.

Der Befehl interface.launch() startet die webbasierte Gradio-Plattform, auf der Nutzer verschiedene Werte testen können. Dadurch können sie die erzeugten adversarialen Bilder sehen und analysieren, um zu verstehen, wie verschiedene Epsilon-Werte die Ergebnisse beeinflussen.

Vergleich zwischen FGSM und anderen adversarialen Angriffsmethoden

Die folgende Tabelle fasst den Vergleich zwischen FGSM und anderen adversarialen Angriffsmethoden zusammen:

| Angriffsmethode | Beschreibung | Vorteile | Nachteile |

|---|---|---|---|

| FGSM | Einfach, effizient, nutzt das Gradienten-Vorzeichen zur Erzeugung adversarieller Beispiele | Schnell, leicht umzusetzen, gut für erste Schwachstellenanalysen | Erzeugt leicht erkennbare Störungen, weniger wirksam gegen robuste Modelle |

| PGD | Iterative Version von FGSM, verfeinert Störungen über mehrere Schritte | Effektiver bei der Erzeugung adversarieller Beispiele, schwerer zu verteidigen | Rechenaufwendig, zeitintensiv |

| CW | Carlini & Wagner Angriff, minimiert Störungen, um sie weniger erkennbar zu machen | Sehr effektiv, erzeugt minimale Störungen | Komplex in der Umsetzung, hoher Rechenaufwand |

| DeepFool | Findet minimale Störungen, um Eingaben über die Entscheidungsgrenze zu verschieben | Erzeugt kleine Störungen, effektiv für viele Modelle | Rechenaufwendiger als FGSM, weniger intuitiv |

| JSMA | Jacobian-based Saliency Map Attack, zielt auf spezifische Pixel zur Veränderung | Effektiv für gezielte Angriffe, ermöglicht Kontrolle über modifizierte Pixel | Komplex, langsam, erfordert detailliertes Modellverständnis |

Entwickler bevorzugen FGSM für schnelle Berechnungen und einfache Robustheitsanalysen von Modellen sowie für adversariales Lernen. Im Gegensatz dazu setzen sie Methoden wie PGD oder C&W ein, um leistungsstarke adversariale Beispiele zu erstellen, auch wenn diese rechenintensiv sind. Methoden wie DeepFool und JSMA sind besser geeignet, um minimale Störungen und Merkmalsbedeutung zu analysieren, verbrauchen jedoch mehr Rechenleistung.

Fazit

Dieser Artikel untersucht die Fast Gradient Sign Method (FGSM), eine entscheidende Technik im adversarialen maschinellen Lernen. Diese Methode deckt Schwachstellen neuronaler Netzwerke auf, indem sie minimale Änderungen an Eingaben nutzt und Gradienten in Bezug auf die Verlustfunktion berechnet. Die resultierenden Störungen können Modellvorhersagen drastisch beeinflussen. Daher ist das Verständnis der mathematischen Grundlagen von FGSM entscheidend für die Entwicklung robuster maschineller Lernsysteme, die nicht durch adversariale Angriffe zusammenbrechen.

Die praktische Implementierung mit TensorFlow und Gradio zeigt die reale Anwendung von FGSM. Nutzer können verschiedene Epsilon-Werte ausprobieren und beobachten, wie sich diese auf die erzeugten adversarialen Bilder auswirken. Dieses Beispiel unterstreicht sowohl die Effizienz von FGSM als auch die Anfälligkeit von KI-Systemen für gezielte Angriffe. Es besteht die Notwendigkeit, robuste Sicherheitsmaßnahmen zu etablieren, um optimale Sicherheit und Zuverlässigkeit in KI-Systemen zu gewährleisten.